Realidad Aumentada e Interacción. Si pudiéramos tocar los bits…

Ana M. Bernardos, IPTC.

Actualmente, la frontera entre lo físico y lo digital se difumina cada vez más. Los objetos conectados son productores intensivos de datos, y muchos recursos digitales cobran sentido cuando se observan en un espacio físico concreto. La Realidad Aumentada (augmented reality, AR) permite navegar e interactuar con información y recursos digitales superpuestos, integrados en el espacio.

La historia de la AR es larga; ya en 1968 Sutherland diseñó el primer dispositivo-casco (head mounted display, HMD) que permitía visualización orientada de contenidos virtuales. A principios de la década de 2000, llegaron las primeras aplicaciones para dispositivos móviles. Una pionera fue AR tennis para teléfonos Nokia, en el momento en que la compañía dominaba el mercado de los dispositivos móviles. Aún muy sencilla, hizo que la tecnología ganase adeptos. La primera campaña publicitaria con recursos AR para revista en papel fue de BMW, en 2008: anunciaba su nuevo Mini. Durante la década de 2010, aparecieron diversas empresas especializadas en la prestación de servicios de AR y los juegos móviles AR siguieron creciendo en popularidad, culminando con el lanzamiento en 2016 de Pokemon Go, uno de los juegos móviles más populares jamás creados.

Los dispositivos de visualización AR actuales van más allá de los smartphones o dispositivos móviles, si bien estos son los más accesibles y cada vez integran más tecnología que facilita la optimización de la experiencia (por ejemplo, comienzan a incluir tecnología LiDAR, con la consiguiente mejora de mapeado 3D3). En concreto, las gafas inteligentes suscitan muchas expectativas. A finales de la década de 2010 y principios de la de 2020, se empezó a rumorear que Apple y Facebook iban a irrumpir en el ecosistema de empresas fabricantes de gafas inteligentes, pero los rumores continúan hoy en día (2021-2023 puede ser el período decisivo). Algunos de los productos que están en el mercado que permiten que se visualice información “simple” bidimensional sobre el espacio real son VUZIX, SOLOS, Everysight Raptor, VUE, Snap, Amazon Echo, Google Glass Enterprise (2nd. ed.).

Cuando se persigue una visualización inmersiva, en la que se puedan manipular elementos digitales tridimensionales interactivos, se recurre a los head-mounted displays. Estos dispositivos de visualización se llevan ajustados a la cabeza (integrados en un casco o con algún tipo de sujeción) y garantizan que, sin importar el movimiento de la cabeza, la pantalla de visualización permanecerá justo frente a los ojos del usuario. Los HMD para AR se suelen comercializar como dispositivos de realidad mixta (mixed reality) para enfatizar las capacidades interactivas del usuario con los recursos digitales. La oferta actual incluye productos como Microsoft’s Hololens 2 (566 gramos de peso y campo de visión diagonal de 52º), Magic Leap (50 grados, 316 gr.), Nreal (52 grados, compatible con Android, 85 gr.), Third Eye Gen X2 (42 grados, 277 gr.) o la simple Zappar Zapbox (smartbox para iPhone y teléfonos Android seleccionados).

La AR implica poder interactuar, no sólo visualizar. Los métodos de interacción ciertamente dependen del dispositivo utilizado. En el caso de los HMD de realidad aumentada, la interacción a través de gestos manuales, aéreos, sean estos dinámicos o estáticos (posiciones de manos) se suele combinar con comandos de voz, proporcionando (o, al menos, intentándolo) una interfaz de usuario “natural” (natural use interface, o NUI). Utilizando, además, interacción “háptica” es posible “percibir” los recursos virtuales mediante el uso de estímulos sintéticos que tratan de imitar la interacción real a través de las manos (y en ocasiones, del cuerpo). Hay diversos tipos de dispositivos hápticos; en general se suelen clasificar dependiendo de si el efecto háptico se produce sobre la piel del usuario (dispositivos cutáneos o táctiles – en caso de que el efecto sea sobre los dedos) o está en cambio basado en la percepción de fuerzas (dispositivos kinestésicos). En este último caso, los dispositivos intentan simular la rigidez real (la relación entre la fuerza aplicada a un objeto y la deformación resultante de su superficie). Los dispositivos kinestésicos suelen tener el problema de la falta de portabilidad (deben permanecer estáticos / anclados en una posición). La realimentación háptica puede integrarse en dispositivos wearable (pulseras, anillos, guantes, etc.), en dispositivos que se pueden asir con la mano (graspable, puede ser el caso de un joystick, un mando o, incluso, un teléfono móvil) o en soluciones que ofrezcan una experiencia sin contacto (en el aire) que no requiera que el usuario lleve ningún accesorio. En la Fig. 1 se muestran algunos ejemplos de objetos wearable y graspable, muchos de ellos desarrollados para integrarse con sistemas de juego en realidad virtual.

Figura 1. Algunos dispositivos de interacción háptica. 1) Dispositivo graspable Phantom Premium de 3DSystems, evolución comercial actual del sistema de 1995 de Thomas Massie. 2) Guante Dexmo de Dexta Robotics para VR. 3) Prototipo de brazalete Tasbi de Facebook, proporciona combinación de vibraciones y presión (ajuste dinámico de tensión) para imitar la realimentación háptica de los objetos virtuales. 4) Interacción con entorno virtual con EXOS Gripper de Exii.

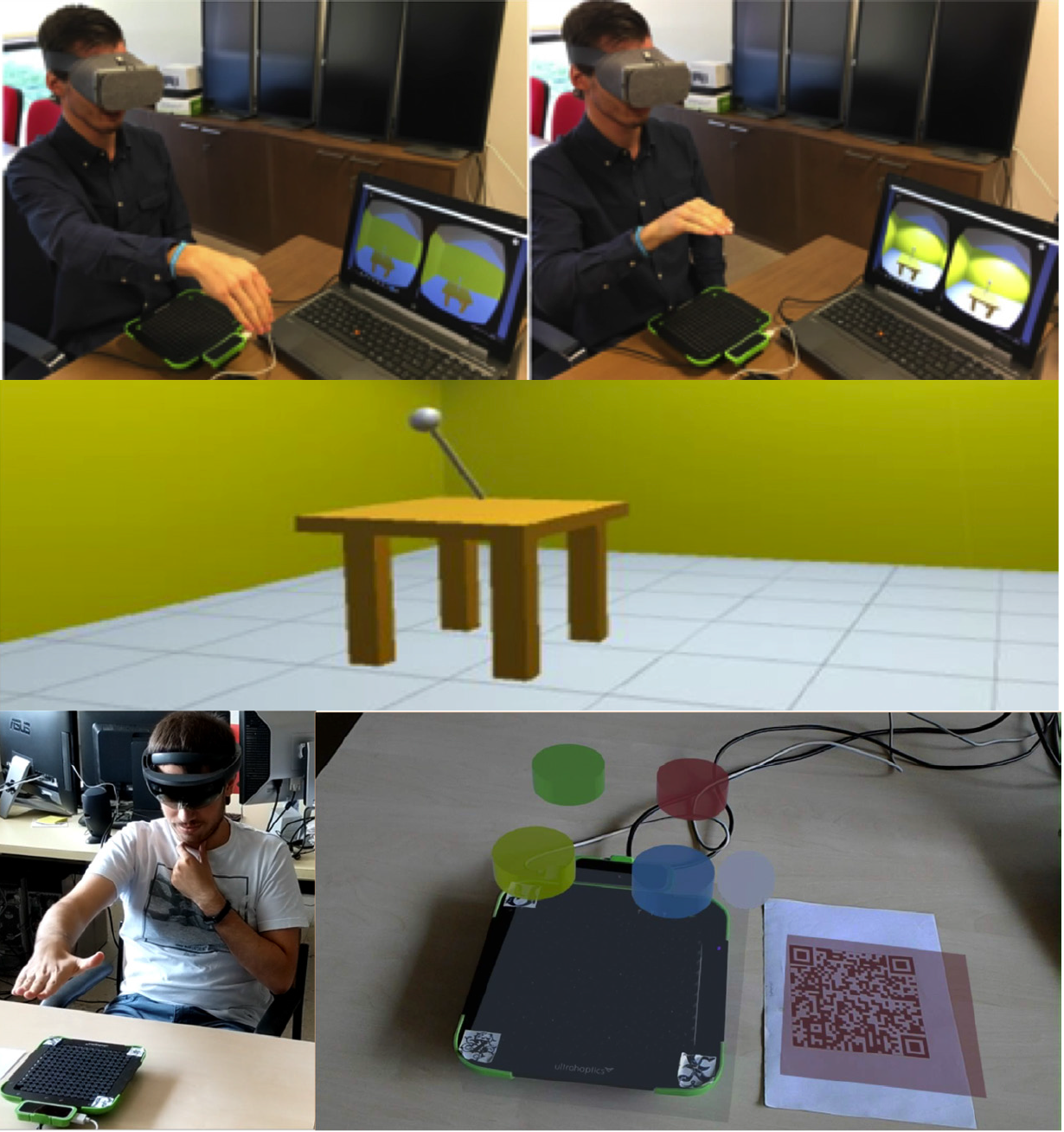

Un ejemplo de dispositivo háptico sin contacto es STRATOS (antes Ultrahaptics) de la empresa Ultraleap. Se trata de una superficie de interacción háptica cutánea formado por una placa de transductores de ultrasonidos. Permite configurar una cuadrícula de emisores de flujo de aire, en términos de número y altura de puntos de control, frecuencia e intensidad de emisión para generar diferentes sensaciones. El dispositivo Ultrahaptics integra hardware Leap Motion para ubicar la mano y detectar gestos. En la Fig. 2 se puede ver cómo dos usuarios realizan tareas utilizando un dispositivo de este estilo para recibir “sensación de interacción” en la mano. En el primer caso, el usuario debe accionar una palanca en un entorno virtual. El sistema háptico genera una realimentación que permite que el usuario identifique la posición de la palanca y la modifique. En el segundo caso, el usuario juega a “Simón Dice”: debe recordar una secuencia de colores y replicarla, presionando los botones virtuales; el usuario puede percibir la resistencia de un botón antes de empujarlo.

Figura 2. Usuarios utilizando VR y AR con una interfaz háptica sin contacto (Ultrahaptics). Fuente: Laboratorio de Experiencias de Espacios del Futuro. Information Processing and Telecommunications Center, Universidad Politécnica de Madrid.

Es obvio que los dispositivos de visualización de AR son cruciales para la generalización de estos sistemas y de ellos, en parte, depende la aceptación de la tecnología y su uso generalizado. También es cierto que están avanzando y mejorando con rapidez, y que las comunicaciones 5G permiten ahora hacer realidad servicios conectados que eran imposibles. Entre las barreras que pueden ralentizar la adopción, existen aún aspectos que resolver relacionados con la medida de la rentabilidad de la inversión; los dispositivos son aún costosos, la integración en los procesos y sistemas existentes puede suponer un esfuerzo importante (en particular, en aplicaciones industriales) y, además, el aumento de la productividad aún no está suficientemente argumentado. Por ejemplo, hay estudios que, en evaluación neurológica, explican la mejora de la eficiencia cuando se utilizan sistemas AR frente a cuando no se integran, pero esta mejora no es conscientemente percibida por el usuario.

Por otra parte, algunos expertos piensan que estos sistemas pueden sobrecargar a los usuarios, dificultando la toma de decisiones, lo cual resulta contraproducente desde el punto de vista de los objetivos de los sistemas. Sin duda quedan pendientes muchos retos (y más si se extiende el uso de estos sistemas al ámbito social, en el que los aspectos de privacidad ya originaron controversia en el pasado), pero también, sin duda, se abren muchas oportunidades.

Share this:

Latest news

Categories